今日、Googleのウエブマスターツールからメールが、何々?

Googlebotがrobots.txtにアクセスを試みたけどエラー100%なんで、もうクロールしないよ。

って…どういうこと?

クロールしないってことは、検索されても表示されないの?

仕事用のマジなサイトなのに(涙

Google先生の説明はレベル高すぎ

ウェブマスターツールに行って、説明を読みますが…

これ日本語?

robots.txtってファイルにアクセスできないみたいだけど、

そんなファイルあるのか?

サーバーを覗いても、そんなファイルないし。

少し調べてみると、robots.txtはgoogle先生に見てほしくないページを書いておくものらしい。

そうか、企業が不祥事起こした時に一応その旨をサイトで報告しておきながら

Google先生には隠しておいて、検索しても出ないようにするためのものなんだね。

うちは、そんな隠し事はないし。

むしろGoogle先生にはもっとうちを上位に表示してもらいたいのに。

今度は、試しにブラウザからアクセスしてみると、ファイルノットファウンドじゃなくて

インターナルサーバーエラー。

エラー500って何よ?

他のサイトの分もウェブマスターツールで見てみることに。

するとプロが作ったサイトにはファイルがあって、

サイトマップのありかを書いていたりする。

これいるものなのか?

どうすりゃいいの?

Googleの説明は不親切だけどGoogle先生に聞いてみる

よくわからないが、こうなったらググるしかない。

「robots.txt エラー 」で検索するといろいろ出てくる。

何々・・・

エラーのままだとインデックスされなくなる。

そりゃ困る。

あったこれだ!

検索エンジンのクローラをブロックする必要がない時のrobots.txtの設定は、次の3つのうちどれが適切か?

1.何も書いていないrobots.txtを設置する

2.下の記述を書く

User-Agent: *

Disallow:

3.robots.txtそのものを置かない

今の状態は3だけど、Google推奨は1か2らしい。

んー、じゃあ2で!

良くも悪くもGoogle次第

サーバーに2の内容を書いたrobots.txtを置いて、

再度ウェブマスターツールに見てもらったら

OKの返事。

これで本当にOK?

Googleから訳わからんメールがきて、

Googleの対処法読んでも理解できず、

Googleで調べるって

良くも悪くもネットはGoogle次第ですなぁ。

下記記事には大変お世話になりました。

クローラをブロック“しない”時のrobots.txtの設定

robots.txtをエラー状態にするとインデックスが削除されてしまうという怖~いお話

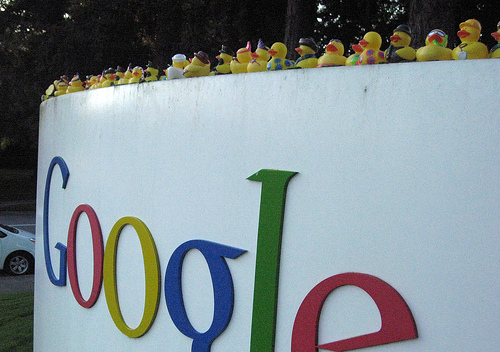

photo credit: Yahoo! Inc via photopin cc